主要内容来自这里。以下是我的步骤:

下载WikipediaDumpReader并安装(deb格式);

下载维基百科文章离线dump包,英文版和中文版。注意在众多文件中选择以”pages-articles.xml.bz2”结尾的那个文件;

在bash下运行“wikipediadumpreader”命令启动WikipediaDumpReader;

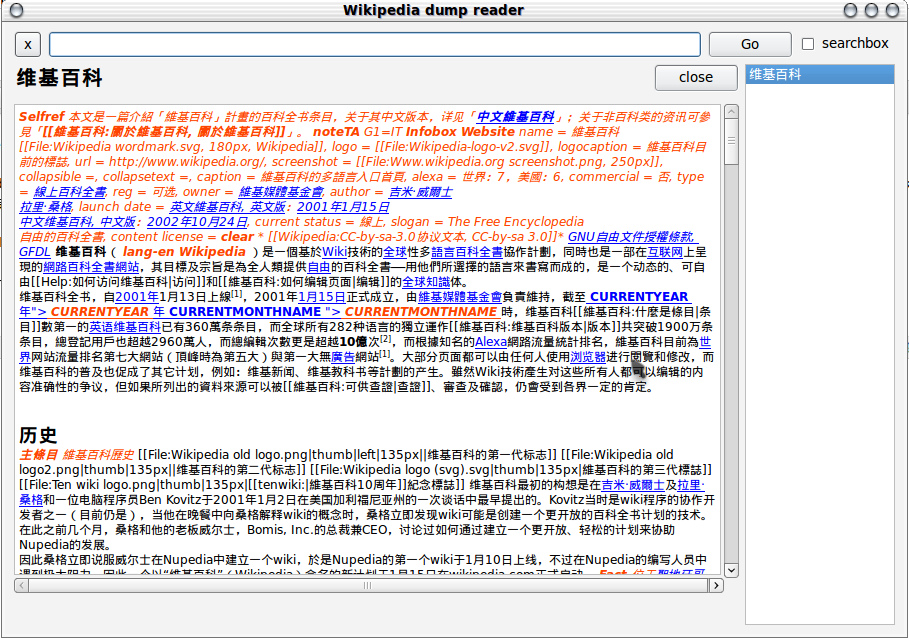

选择本地的”pages-articles.xml.bz2”文件,第一次导入会创建index。对于中文版来说这个过程大概会用5到7分钟。索引创建完成之后,主界面如下:

- OK.

PS:

在我的机器上,wikipediadumpreader 构建 “enwiki-20111007-pages-articles.xml.bz2”的索引用时2小时17分钟完成77%,整个过程我中间吃午饭去了,估计有3个小时,生成的索引文件如下:

1 | enwiki-20111007-pages-articles.blocks.idx |

只要把这几个文件和“enwiki-20111007-pages-articles.xml.bz2”文件放在同一个目录下,以后复制到其它机器上也不用再生成这几个索引文件了。

Added@20120530:

WikipediaDumpReader默认的显示字体太小,可以通过以下方法修改默认字体的大小:

打开”/usr/share/wikipediadumpreader/dumpReader.py”文件(修改需要sudo权限),将其中的”fontSize = 9”修改为”fontSize = 11”或其它你想要的字体大小即可。该方法参考了这里。

Updated@20150506:

在Ubuntu 14.04下,直接安装deb包会报错:”Cannot install ‘python-qt4:i386’”,我怀疑是因为我的Ubuntu是AMD64版本导致的。在这种情况下,可以直接下载tar.gz包,从源代码(python)运行是完全没问题的。另外,貌似WikipediaDumpReader的最后一个版本是2009年发布的,这么好的东东没有再维护了,可惜!